Warum räumliche Intelligenz der fehlende Baustein der humanoiden Robotik ist

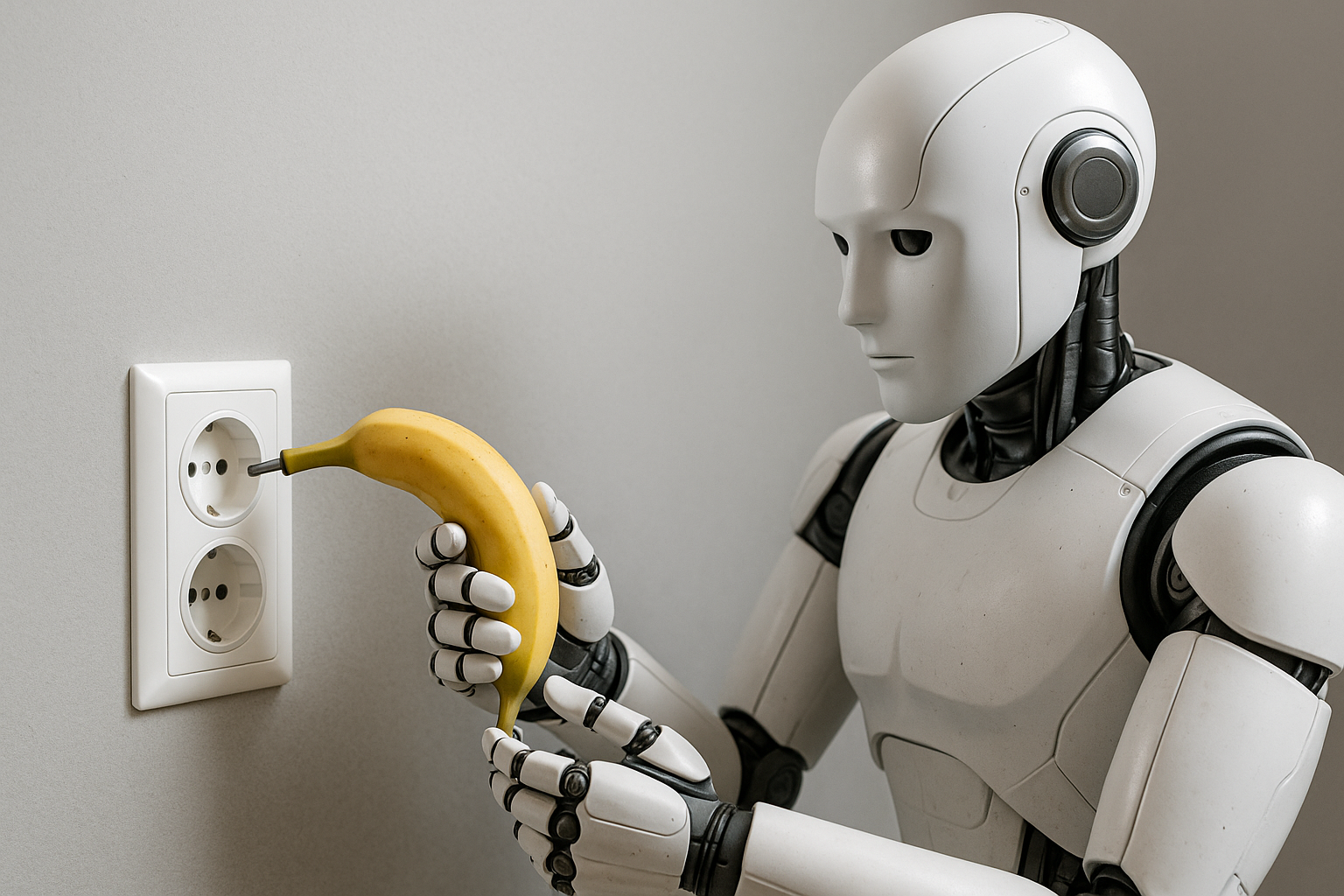

Der neue humanoide Roboter NEO von 1X kann gehen, greifen, lächeln – und ist ab sofort vorbestellbar. Zum ersten Mal zieht ein Humanoid ins Wohnzimmer ein. Doch hinter der polierten Hardware steckt noch eine simple Wahrheit: Er denkt nicht selbst. NEO funktioniert, weil irgendwo ein Mensch zusieht, korrigiert und eingreift.

Die Hardware der humanoiden Robotik ist längst auf der Überholspur. Aber das eigentliche Rennen um Intelligenz, Verständnis und Handlungskompetenz hat gerade erst begonnen. Denn die Körper dieser neuen Maschinen sind da – aber sie verstehen die Welt noch nicht, in der sie sich bewegen.

Der Stand der Dinge: Beeindruckende Körper, begrenzte Köpfe

Wer die Automatica 2025 besucht hat, spürte die Energie: Hersteller zeigen ihre Humanoiden – diese Zukunft scheint zum Greifen nah. NEURA Robotics präsentierte seinen 4NE1 in der dritten Generation – mit neuen Gelenken, Sensorik und weicher Haut. Parallel kündigte Schaeffler eine Partnerschaft an, um bis 2035 mehrere tausend humanoide Roboter in der Industrieproduktion einzusetzen. Das ist kein Science Fiction mehr, sondern industrielle Roadmap.

Auch bei Agility, Apptronik oder Tesla Optimus zeigen die Prototypen erstaunliche Fortschritte in Balance, Laufbewegung und Feinmotorik. Die Hardware ist kein Engpass mehr: elektrische Antriebe, taktile Haut, Kamera-Arrays, Sensorfusion – alles funktioniert, effizient, leise, skalierbar. Der Engpass liegt woanders: im Gehirn.

Heute werden selbst die besten Roboter noch in engen Umgebungen betrieben – sie bewegen sich in begrenzten Produktionsumgebungen, sie greifen vorbereitete Objekte, folgen Skripten oder erhalten noch Remote-Assist durch Operatoren. Sie bewegen sich – aber sie können sich noch nicht frei in unserer Welt bewegen und orientieren.

Die Hardware ist schneller als der Kopf

Diese Schere zwischen Körper und Kopf wird zur neuen Gretchenfrage der Robotik. Der Sprung von einem manipulationsfähigen Gerät zu einem intelligenten Agenten, der eine Welt versteht, plant und agiert, erfordert eine neue Generation von KI-Systemen: räumliche oder „spatial“ Intelligenz.

Denn das, was wir Menschen selbstverständlich tun – uns im Raum orientieren, Bewegungen antizipieren, Objekte erkennen, Ursachen verstehen – ist für heutige KI-Systeme noch unzugänglich. Large Language Models wie GPT oder Claude können sprechen, erklären, planen – aber sie haben keinen Körper, keinen Raum, keine Physik. Sie leben in Text, nicht in der Welt.

Mit den LLMs haben wir die Spitze der menschlichen Evolution – die Sprache – simuliert, bevor wir die Basisfunktionen des Kleinhirns verstanden haben. Genau diese evolutionäre Reihenfolge müssen wir jetzt in der KI nachbauen.

Warum Humanoide Weltmodelle brauchen

Ein Humanoid, der eine Tasse greifen, einen Tisch abwischen oder eine Schublade öffnen soll, muss den Zustand der Welt repräsentieren, vorhersagen und fortschreiben können.

Er muss wissen, was sich wo befindet, was passiert, wenn er etwas bewegt – und wie sich Aktionen über Zeit auswirken.

Das ist die Aufgabe sogenannter Weltmodelle (World Models): Sie bilden die physische und semantische Struktur einer Umgebung in einem neuronalen Gedächtnis ab – inklusive Raum, Bewegung, Kausalität und Dynamik.

Damit verschmelzen Wahrnehmung (Vision), Verständnis (Semantik) und Handlung (Action) zu einer Einheit.

Nur wenn Maschinen solche Modelle besitzen, können sie tatsächlich lernen, im Raum zu denken – und nicht nur über ihn zu reden.

Der Stand der Forschung: Die neuen Weltbauer

Genau damit beschäftigt sich gerade die Forschung und auch die Industrie. Hier ein Überblick:

Fei-Fei Li – „Von Worten zu Welten“

Die Stanford-Professorin und Gründerin von World Labs nennt „Spatial Intelligence“ die nächste Frontier der KI. Mit ihrem neuen Modell Marble will sie erstmals 3D-Welten generieren, die physikalisch konsistent bleiben – inklusive Objekte, Tiefe und Dynamik.

Marble basiert auf drei Prinzipien: Generativ, Multimodal, Interaktiv. Das Modell erzeugt virtuelle Räume, versteht Sprache, Bild und Bewegung gleichzeitig – und kann Aktionen in diesen Räumen simulieren.

Ziel ist nicht Textverständnis, sondern Weltverständnis. Damit liefert Li die theoretische Architektur für das, was Roboter künftig als internes Weltmodell brauchen: ein kohärentes Bild der Realität, in dem sie handeln können.

Yann LeCun – „Vorhersagen statt Nachplappern“

Der Ex-Meta-Chef-Forscher Yann LeCun verfolgt einen anderen Weg. Sein System V-JEPA (Video Joint Embedding Predictive Architecture) ist kein generatives Modell, sondern ein prädiktives. Es lernt, zukünftige Zustände aus vergangenen Beobachtungen vorherzusagen – also „Was passiert, wenn…?“. LeCun kritisiert die aktuellen generativen Modelle als „wordsmiths in the dark“: eloquent, aber ahnungslos über Physik und Kausalität.

Seine Vision: KI, die nicht nur Inhalte erzeugt, sondern die Welt begreift, in der sie agiert.

Mit V-JEPA 2 erweitert Meta diese Architektur um physik-basierte und sensorische Repräsentationen – ein Baustein für Roboter, die ihre Umwelt wirklich verstehen, statt sie zu beschreiben.

NVIDIA – „Compute trifft Welt“

NVIDIA verbindet beide Stränge: Mit GR00T N1, dem offenen Foundation-Modell für Robotik, verknüpft der Konzern seine Simulationsplattform Omniverse, die Trainingsumgebung Isaac, und die neue Hardware-Generation Thor/Jetson zu einem End-to-End-System für embodied AI. GR00T versteht Bild, Video, Sprache und Handlung – Vision-Language-Action (VLA). Damit entsteht eine skalierbare Trainings-Pipeline, die synthetische und reale Daten zu räumlichem Lernen verknüpft.

NVIDIAs Strategie ist klar: Die GPU als Gehirn der Weltmodelle – von der Simulation bis zum Roboterkopf.

Google DeepMind – RT-2

DeepMind hat mit RT-2 den Versuch gestartet, Sprach- und Bildverständnis mit Robotik-Aktion zu verschmelzen. Das Modell kann aus Text-Anweisungen Handlungen ableiten („pick up the blue cup“), indem es Web-Wissen in physische Aktionen übersetzt. Ein wichtiger Schritt, aber der Transfer von virtueller Semantik zu realer Dynamik bleibt unzuverlässig. Was im Labor funktioniert, kollabiert oft im Alltag – genau dort, wo Weltmodelle robust sein müssen.

OpenAI – Sora 2 als Welt-Simulator

OpenAIs Videomodell Sora 2 zielt darauf, physikalisch konsistentere und steuerbare Simulationen zu erzeugen. Noch kein echtes Weltmodell, aber ein Proto-System, das Zeit, Bewegung und Ursache-Wirkung zusammenführt. Damit entsteht ein synthetischer Trainingsraum für Roboter-KI – die virtuelle Sandbox, bevor reale Motoren anlaufen.

Warum das alles so schwierig ist

Ein Weltmodell muss gleichzeitig

- sehen (3D-Wahrnehmung),

- erinnern (Zustände fortschreiben),

- verstehen (Semantik und Physik verknüpfen),

- planen (Aktionen im Raum),

- und lernen (aus Fehlern und Feedback).

Diese Integration ist komplexer als alles, was LLMs je leisten mussten. Sprache ist linear. Welt ist multidimensional. Das macht Weltmodelle zu den aufwendigsten KI-Systemen, die je trainiert wurden – mit exponentiellem Bedarf an Sensorik, Daten und Rechenleistung.

Humanoide brauchen Weltmodelle – und umgekehrt

Die Beziehung ist symbiotisch: Humanoide liefern die Daten, Weltmodelle liefern den Verstand. Erst durch permanentes Feedback aus realer Sensorik – Kamera, Tiefe, Kraft, Bewegung – entstehen die Datenströme, aus denen KI räumlich denken lernt.

Und umgekehrt geben Weltmodelle den Robotern die Fähigkeit, mit Unsicherheit, Veränderung und Kontext umzugehen. Die Humanoiden von morgen müssen all diese Fähigkeiten nach und nach lernen. Das geht nicht, indem ein einzelner Anbieter Use Case für Use Case selber durcharbeitet. Das Lernen der Welt selbst muss skaliert werden.

Wo wir heute stehen – und der NEURA Shortcut

Nach Jahrzehnten reiner Laborforschung wird klar: Der Engpass humanoider Robotik ist Wissen – und dieses Wissen entsteht nicht in Videos, sondern in realen Prozessen. Genau hier setzt NEURA an – und unterscheidet sich von Tesla, Google, OpenAI oder 1X.

Während Big Tech auf große, generalistische Modelle setzt, verfolgt NEURA einen domänenorientierten, datengetriebenen Plattformansatz.

Statt universeller Generalisten baut NEURA spezialisierte Worker für klar definierte Einsatzfelder, immer zusammen mit Partnern, die jeweils Spezialisten in ihren Domänen sind. So entstehen in den nächsten Monaten Modelle für Fertigung & Montage, Logistik & Intralogistik, Qualitätskontrolle, Reinigung & Facility, Krankenhaus & Laborlogistik sowie Service & Hospitality.

In den NEURA Gyms lernt 4NE1 in realen Szenarien: Werkstücke, Fördertechnik, Paletten, Krankenhausmaterial, Menschen. Nicht simuliert – Realphysik in Echtzeit. So entstehen Datensätze aus Zuständen, Aktionen, Fehlern und Korrekturen – genau das, was heutigen Weltmodellen fehlt.

Der Plan: Im Neuraverse werden diese Fähigkeiten als Skills gespeichert und geteilt. Eine Reinigungspipeline aus Stuttgart wird ein Modul für Zürich oder Tokio, Montageprozesse werden wiederverwendbare Bausteine. Durch die massive Skalierung über Partner kann schneller herausgefunden werden, welche Use Cases überhaupt konkret schon jetzt funktionieren und wo man besser auf weiterentwickelte Weltmodelle wartet.

Mit Sicherheit ein guter Plan, um die Zeit zu nutzen, die Fei-Fei Li, LeCun oder OpenAI mit benötigen, um ihre generischen Weltmodelle weiter zu bringen.

Die weitere Reise

Die Zukunft der humanoiden Robotik entscheidet sich nicht im Showroom, sondern im Zusammenspiel von Weltverständnis, Daten und industrieller Realität. Die Körper sind bereit. Die Gehirne entstehen. Spezifische Anwendungen werden z.B. bei Neura mit dem datenzentrierten Ökosystem, schon jetzt real.

Für universelle humanoide brauchen wir Weltmodelle. Universelle Humanoide werden erst produktiv, wenn sie räumlich denken, nicht nur motorisch handeln. Und sie werden erst sicher, wenn sie Kausalität verstehen, nicht nur Bewegungen ausführen.

Wir stehen heute dort, wo wir bei Smartphones 2005 standen oder bei der Cloud 2008: Die Architektur entsteht – jetzt entscheidet sich, wer das Betriebssystem der nächsten Dekade baut. Die Körper der Humanoiden haben sich bereits entwickelt. Jetzt baut die Industrie ihr Gehirn.