Warum KI-Märkte die neue Weltordnung formen

Der entscheidende Bruch im KI-Markt verläuft nicht zwischen besseren und schlechteren Modellen. Er verläuft zwischen Systemen, denen Autonomie zugemutet wird, und solchen, denen man sie noch nicht anvertraut. Diese Trennlinie ist inzwischen empirisch sichtbar, und sie war in Davos ein unausgesprochenes aber präsentes Thema.

Anthropic hat mit Claude Code innerhalb weniger Monate eine jährliche Umsatzrate von rund einer Milliarde US-Dollar erreicht. Entscheidend ist nicht die Zahl, sondern die Quelle. Es handelt sich weder um ein Massenprodukt noch um einen Konsumentenmarkt, sondern um agentische Nutzung. Claude Code schreibt eigenständig Code, verändert Repositories, führt Tests aus und korrigiert Fehler iterativ. Die Nutzung ist teuer, energieintensiv und bewusst nicht auf Reichweite optimiert. Autonomie steht vor Distribution.

OpenAI steht strategisch an einem anderen Punkt. Trotz rund 900 Millionen Nutzern und zuletzt etwa 20 Milliarden US-Dollar Umsatz projiziert das Unternehmen bis 2028 einen kumulierten Free-Cash-Outflow von über 110 Milliarden US-Dollar. Parallel sucht OpenAI neue Monetarisierungswege. Die Einführung von Werbung in ChatGPT ist dafür das sichtbarste Signal.

Das ist kein Randdetail. Werbung bedeutet, dass ein System nicht mehr ausschließlich im Auftrag seines Nutzers handelt. Es trägt Drittinteressen.

Demis Hassabis (Quelle) kritisierte diesen Schritt in Davos offen. Google plane keine Werbung in Gemini, weil ein Agent, der im Auftrag des Nutzers handelt, keine fremden Interessen tragen dürfe. Dario Amodei (Quelle) formuliert es noch schärfer. Forschung müsse Vorrang vor Produktdruck haben. Vertrauen lasse sich nicht nachträglich hinzufügen.

Der Markt trifft hier bereits eine Auswahl. Nicht Reichweite entscheidet, sondern Delegierbarkeit. Nicht Monetarisierung zuerst, sondern Vertrauen zuerst.

Agenten verschieben den Ort der Entscheidung

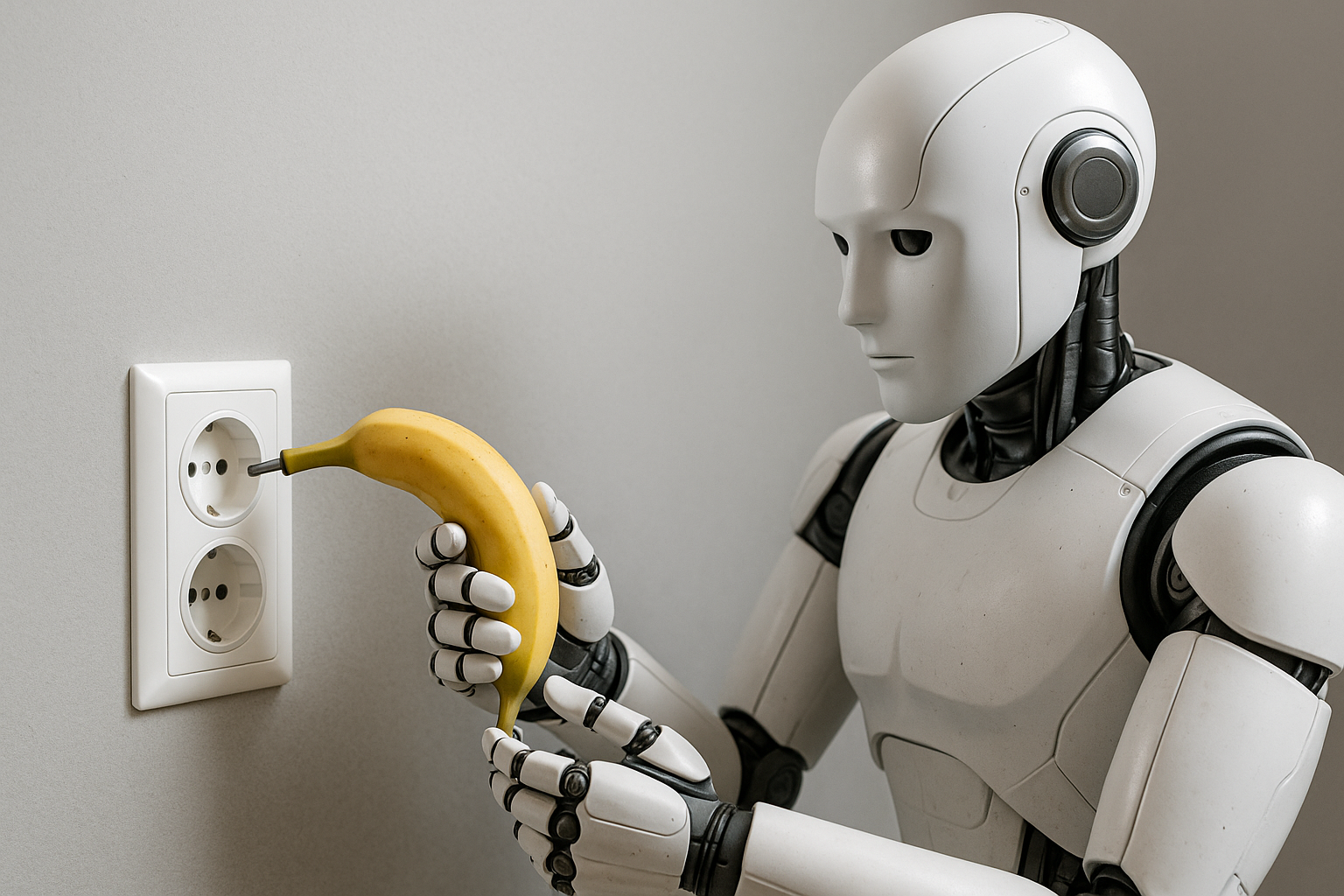

Diese Spaltung folgt keiner Ideologie, sondern einer technischen Konsequenz. Chatbots beantworten Fragen. Agenten handeln. Sie greifen auf Dateisysteme zu, schreiben Code, verändern Prozesse und stoßen reale wirtschaftliche Abläufe an. Jede zusätzliche Autonomiestufe verschiebt Verantwortung.

In klassischen Softwaremärkten war Vertrauen vorgelagert. Verträge, Haftung und institutionelle Absicherung definierten den Rahmen, in dem Systeme eingesetzt wurden. In agentischen Systemen bricht dieses Modell. Entscheidungen entstehen in Millisekunden, ohne menschliche Freigabe, mit irreversiblen Effekten.

Kein Gesetz entscheidet in Echtzeit. Kein Gericht greift während der Ausführung ein. Wenn Systeme handeln, muss Vertrauen im System selbst liegen.

Davos 2026: Ein Ort ohne Sprache für Vertrauen

Diese Verschiebung war in Davos deutlich spürbar. Das World Economic Forum wirkte weniger wie ein Zukunftskongress und mehr wie ein Lagezentrum. CEOs sprachen nicht über Visionen, sondern über operative Zumutungen. Welche Entscheidungen lassen sich noch delegieren? Wo endet Verantwortung? Was ist nicht mehr rückholbar?

Auffällig war die Leerstelle. Regulierung dominierte die Sprache, Vertrauen kaum. Dabei war implizit klar, dass Regulierung dort an Grenzen stößt, wo Systeme schneller handeln als Institutionen reagieren können.

Mark Carney (Quelle) sprach vom Ende einer angenehmen Fiktion. Gemeint waren Handelsabkommen. Tatsächlich betrifft die Fiktion die Vorstellung, dass Institutionen der primäre Ort von Ordnung bleiben, während Entscheidungen längst woanders fallen.

Der tiefere Bruch: Vom Finden zum Bauen

Der Kontext dieses Wandels reicht über KI hinaus. Zwischen 2010 und 2014 überschritten drei fundamentale Inputs menschlicher Entwicklung jeweils eine Schwelle: Energie, Intelligenz und Biologie. Solar- und Batteriekosten begannen exponentiell zu fallen. AlexNet zeigte 2012, dass neuronale Netze skalieren. CRISPR machte im selben Jahr Genome editierbar. Alle drei wechselten von Extraktion zu Lernkurven. Ressourcen werden nicht mehr primär gefunden und verteilt, sondern gebaut und verbessert.

Damit kippt die Logik von Ordnung. Macht entsteht nicht mehr aus Besitz, sondern aus der Fähigkeit, Lernsysteme zu orchestrieren. Die staatliche Vertrauenslogik – langsam, vorgelagert, institutionell – passt nicht mehr zu Systemen, die sich in Nutzung selbst verbessern.

Alignment wird zur Marktbedingung

In diesem Umfeld ist Alignment kein ethischer Zusatz, sondern eine ökonomische Voraussetzung. Agenten entfalten ihren Wert nur, wenn man ihnen Zugriff, Ausführung und Prozesshoheit gewährt. Je mehr Autonomie, desto größer der Produktivitätsgewinn und desto höher das Risiko.

Der Markt reagiert darauf nicht normativ, sondern selektiv. Systeme, denen man nicht traut, werden nicht eingesetzt. Systeme, die sich bewähren, skalieren. Auffällig ist, dass die derzeit autonomsten Agentensysteme ausgerechnet von dem Labor stammen, das sich explizit sicherheitsfokussiert positioniert: Anthropic.

Umgekehrt geraten Systeme mit schwächerem Alignment unter Druck. xAI hatte wiederholt Probleme mit Deepfakes, regulatorischer Aufmerksamkeit und Zurückhaltung auf Unternehmenskundenseite. Die Marktlogik ist eindeutig. Alignment erzeugt Vertrauen. Vertrauen ermöglicht Autonomie. Autonomie erzeugt Wert.

Der Markt beginnt, als Koordinationsmechanismus für Sicherheit zu wirken.

Vertrauen entsteht nach der Handlung

Damit verschiebt sich der Ort der Vertrauensproduktion. In der industriellen Ordnung wurde Vertrauen vor der Handlung erzeugt, durch Gesetze, Institutionen und Durchsetzung. In agentischen Märkten entsteht Vertrauen nach der Handlung, durch wiederholte, verlässliche Systemleistung unter realen Bedingungen.

Ein System, dem Autonomie zugemutet wird und das sich bewährt, erzeugt Vertrauen durch Praxis. Dieses Vertrauen skaliert. Es wird reproduzierbar. Und es beginnt, institutionelles Vertrauen funktional zu verdrängen, nicht abrupt, sondern schleichend.

Der Markt wird zum Vertrauensgenerator.

Drei Vertrauensarchitekturen

Vor diesem Hintergrund lassen sich die dominanten Ordnungsmodelle neu lesen.

In der Schweiz entsteht Vertrauen durch institutionelle Stabilität. Rechtsstaatlichkeit, Eigentumsschutz und Berechenbarkeit schaffen eine extrem robuste Basis. Diese Architektur ist ideal für Vermögen und Langfristigkeit, aber zu langsam, um autonome Systeme selbst zum Ordnungsanker zu machen.

In den USA entsteht Vertrauen durch Marktfeedback. Nutzung, Iteration und Skalierung entscheiden. Diese Architektur ist ideal für agentische Systeme, aber volatil und institutionell dünn abgesichert.

In China wird Vertrauen durch Kontrolle ersetzt. Vollständige Systemintegration ermöglicht schnelle Implementierung, erzeugt aber Compliance statt Vertrauen. Diese Architektur ist effizient, aber begrenzt exportfähig.

Die neue Ordnung entsteht dort, wo sich diese Modelle überschneiden – und wo keines allein trägt.

Ownership unter Autonomie

Für Eigentümer verschiebt sich damit die Kernfrage fundamental. Nicht mehr, wie Systeme kontrolliert werden können, sondern welchem System man genug vertraut, um Kontrolle abzugeben.

Ownership unter agentischen Bedingungen bedeutet nicht mehr primär Aufsicht, sondern Entscheidungen über Delegierbarkeit. Diese Entscheidungen sind strukturell. Sie lassen sich nicht iterativ testen, ohne Wirkung zu erzeugen. Wer einem System Autonomie zugesteht, verändert die Ordnung seines Unternehmens, unabhängig davon, ob das System später erfolgreich ist oder nicht.

Verantwortung verschiebt sich zeitlich nach vorne. Sie liegt nicht mehr im Eingreifen, sondern im Zulassen. Nicht im Korrigieren, sondern im Auswählen. Eigentum zeigt sich nicht darin, Systeme zu überwachen, sondern darin, vorab zu bestimmen, welche Systeme handeln dürfen und welche nicht.

Damit entsteht eine neue Form von Irreversibilität. Klassische unternehmerische Entscheidungen konnten angepasst oder zurückgeholt werden. Agentische Delegation wirkt anders. Sie verändert Entscheidungslogiken, Erwartungshaltungen und Haftungsräume zugleich. Verantwortung entsteht nicht im Fehlerfall, sondern im Moment der Architekturentscheidung.

Ownership wird stiller, aber härter. Weniger sichtbar im Alltag, dafür schwerer zu umgehen. Wer diese Entscheidungen nicht bewusst trifft, trifft sie implizit, durch Nicht-Entscheiden, durch Übernahme fremder Standards, durch den Einsatz externer Systeme ohne eigene Ordnungslogik.

In dieser Welt ist Vertrauen kein Gefühl und kein kulturelles Kapital. Es ist eine ökonomische Vorleistung. Eigentümer investieren Vertrauen, lange bevor Erträge sichtbar werden, und tragen die Konsequenzen, wenn dieses Vertrauen falsch platziert war.

Technik kann eingeführt werden. Autonomie wird gewährt. Verantwortung aber bleibt unteilbar.

Die eigentliche Frage nach Davos

Die entscheidende Frage lautet nicht, wie KI reguliert oder gebremst werden soll. Sie lautet, wo Vertrauen entsteht, wenn Systeme schneller handeln als Staaten entscheiden können.

Die neue Weltordnung entsteht nicht in Verträgen. Sie entsteht dort, wo KI-Märkte Vertrauen skalieren. Und genau deshalb wird Vertrauen, nicht Kontrolle, zur knappsten Ressource der kommenden Dekade.